Empowering Real-World: A Survey on the Technology, Practice, and Evaluation of LLM-driven Industry Agents

-

ArXiv URL: http://arxiv.org/abs/2510.17491v1

-

作者: Mingming Zhao; Yihong Tang; Min Zhang; Shixiong Kai; Xiaoguang Li; Lifeng Shang; Xingshan Zeng; Kaiyang Guo; Kehai Chen; Yuyang Zhang

-

发布机构: Harbin Institute of Technology; Huawei Technologies Co., Ltd.

好的,我已判断这是一篇 [综述] 论文。我将严格遵循综述报告的模板,以原文结构为基础,重点剖析其提出的分类体系,并提炼核心内容。

赋能真实世界:LLM驱动的行业智能体技术、实践与评估综述

本文系统性地回顾了基于大型语言模型(LLM)的行业智能体 (Industry Agents) 的技术、应用和评估方法,旨在为理解和构建下一代行业智能体提供清晰的路线图和理论基础。

行业智能体能力成熟度框架

近年来,基于LLM的通用智能体在处理开放域复杂任务上取得了显著进展。一个通用的智能体框架通常依赖于三大核心技术支柱:记忆(Memory)、规划(Planning)和工具使用(Tool Use)。然而,当通用智能体走向行业应用时,就诞生了“行业智能体”这一概念。

行业智能体是在特定业务场景中,利用领域知识和专用工具来解决真实世界行业问题的自主或半自主系统。相较于通用智能体,行业智能体面临着更严峻的挑战,如金融领域的高时效性和风险、医疗领域的权威知识和安全合规、制造业的物理约束和流程复杂性等。核心问题在于如何将通用智能体框架与深度行业知识、复杂业务流程和严苛安全标准相结合。

分类体系

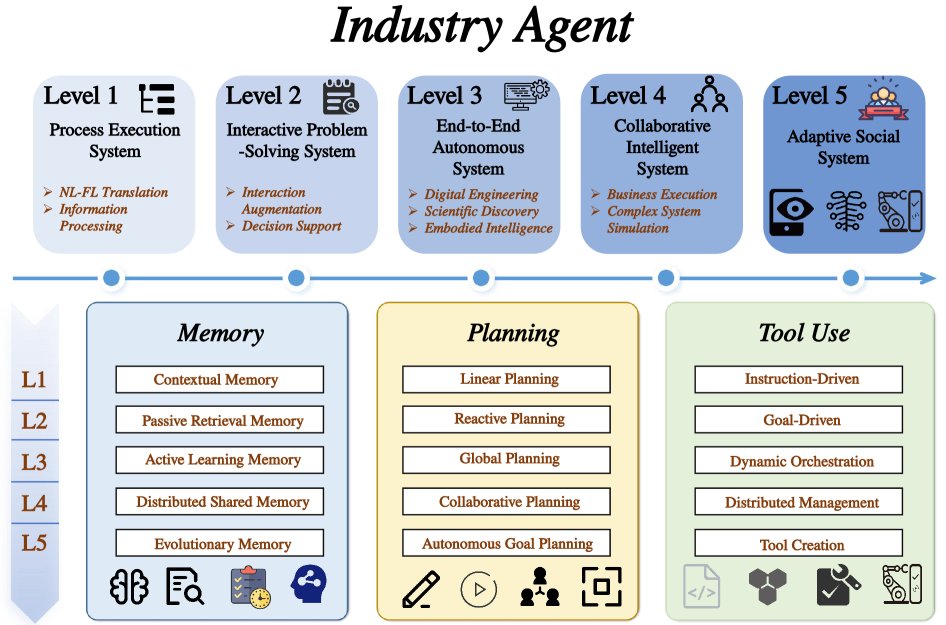

为了系统性地分析行业智能体的演进路径,本文提出了一个面向行业应用能力成熟度的五级框架(L1-L5)。该框架不仅是对智能体能力的划分,更揭示了能力跃迁背后的驱动力——即记忆、规划、工具使用这三大核心技术的演进。

- L1:流程执行系统 (Process Execution System):作为简单的指令执行器,依赖瞬时记忆和固定的线性规划。

- L2:交互式问答系统 (Interactive Problem-Solving System):能够借助外部知识库进行问答,具备基础的检索能力和被动交互规划。

- L3:端到端自主系统 (End-to-End Autonomous System):能够在闭环中独立完成复杂任务,其记忆机制支持主动学习和经验内化,规划能力具备反思和修正。

- L4:自适应协作系统 (Adaptive Collaborative System):由多个智能体协作完成大规模目标,需要分布式和共享的集体记忆,以及协同规划能力。

- L5:自适应社会系统 (Adaptive Social System):形成类似人类社会的智能体社群,其记忆能够跨代演化形成“文化”,规划能力则演化为在复杂博弈中自主生成目标。

这一框架是本文的核心,后续章节将围绕此框架,阐述三大核心技术如何在其演进过程中支撑智能体能力的不断升级。

核心技术演进与能力跃迁

本部分深入探讨记忆、规划、工具使用三大核心技术,分析它们的技术演进如何支撑行业智能体能力的持续升级。

记忆 (Memory)

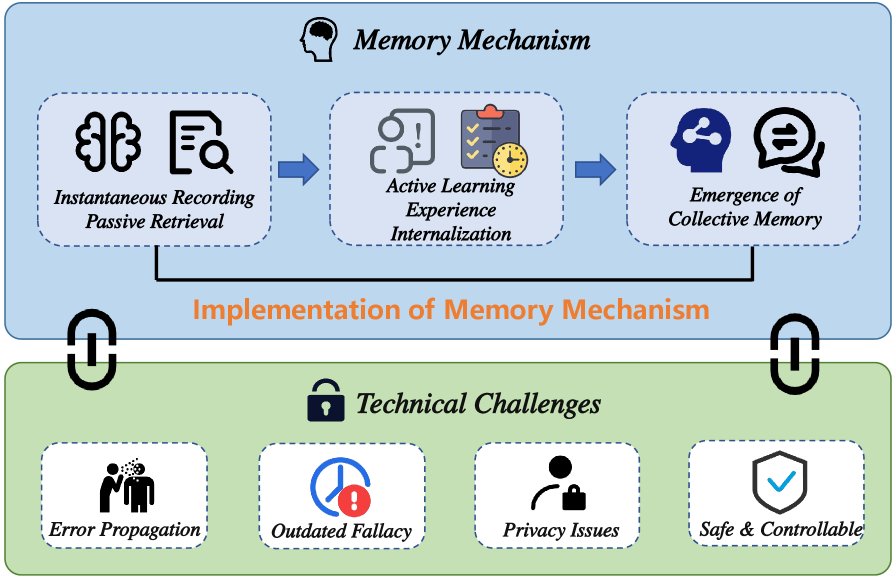

记忆是智能体超越无状态限制、实现学习和适应的关键。其机制的复杂度和成熟度决定了智能体的能力上限。

从瞬时记录到被动检索 (L1-L2)

- L1 - 瞬时上下文 (Instantaneous Context):在流程执行系统中,记忆主要依赖LLM的上下文窗口,是一种临时的、任务导向的工作记忆。例如,ReAct框架中的思维链(Chain of Thought)就是瞬时工作记忆的体现[28]。其局限在于容量有限且易失。

- L2 - 被动检索 (Passive Retrieval):在交互式问答系统中,记忆进化为连接外部知识库,实现了从无状态到“有知识”的转变。其核心是检索增强生成 (Retrieval-Augmented Generation, RAG) [165],使智能体能从外部来源(如维基百科、医疗数据库、代码库)中检索信息以增强回答。此时智能体本身未学会知识,只是一个高效的查询器。

主动学习与经验内化 (L3)

在端到端自主系统中,记忆从被动存储转变为促进学习和经验内化的主动、动态系统。

- 主动学习与反思:智能体通过分析交互历史中的成败来学习。如Reflexion框架[169]通过反思来优化后续行动,Voyager[168]则将成功执行的代码存入可复用的技能库。智能体从信息消费者转变为经验的生产者和提炼者。

- 经验内化:将外部知识转化为内部记忆。传统方法是微调(Fine-tuning),如在医疗、金融等专业领域数据集上微调模型[174, 177]。更精细的技术是知识编辑 (Knowledge Editing),它能在不重新训练的情况下修改模型参数中的特定知识[178, 179]。

- 非参数化内存管理:作为一种更通用的内化方法,它包含内存写入(如将信息结构化存入数据库[39])、内存管理与精炼(如通过反思生成高阶摘要[42, 36])和内存读取(如根据任务检索最相关的记忆[35, 171])。

集体记忆的浮现 (L4-L5)

- L4 - 分布式与共享记忆 (Distributed and Shared Memory):在多智能体协作系统中,所有智能体依赖一个共享的认知空间,即集体记忆。如AutoGen[44]、ChatDev[46]和MetaGPT[45]等框架中,所有角色共享统一的上下文(如需求文档、代码库)。这确保了协作的一致性,是协调复杂业务流程的前提。

- L5 - 演化与文化记忆 (Evolutionary and Cultural Memory):在自适应社会系统中,记忆不仅在智能体间共享,还能跨时间累积、固化和演化,形成类似人类社会的“文化”。它记录群体的成功策略、失败教训和共同价值观,并可被新加入的智能体继承。

记忆管理的现实挑战

高效的记忆机制并非没有风险。研究表明,LLM智能体存在明显的“经验遵循”行为,可能导致错误传播(早期记忆中的错误在后续决策中被放大)和经验错位(过时或无关的记忆对当前任务产生负面干扰)[187]。同时,智能体记忆模块存在隐私泄露的风险,攻击者可能通过提示工程提取存储在记忆中的敏感用户交互信息[188]。因此,开发安全、可控、可维护的记忆系统是核心挑战。

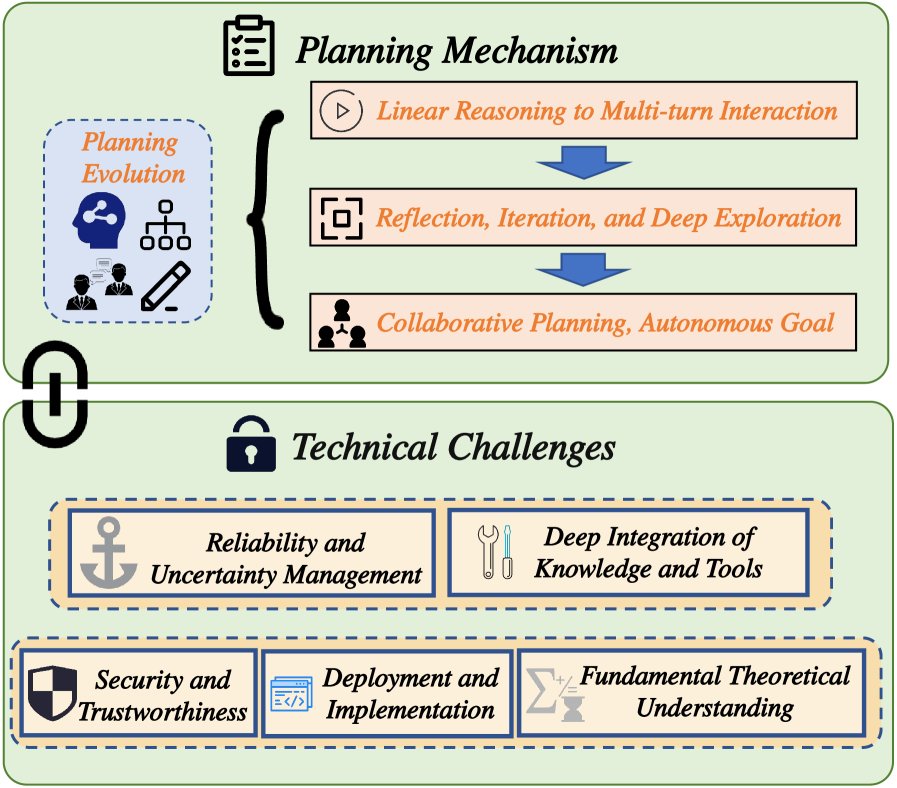

规划 (Planning)

规划能力决定了智能体如何将抽象目标分解为一系列可执行动作,直接关系到其自主性、可靠性和解决问题的复杂度。

从线性推理到多轮交互 (L1-L2)

- L1 - 线性指令分解 (Linear Instruction Decomposition):此阶段规划本质是开环规划,即遵循预设路径完成任务。核心技术是思维链 (Chain-of-Thought, CoT) [51],它引导LLM生成中间推理步骤。但CoT是线性的、一次性的,缺乏与环境的交互和纠错能力。这种规划假设环境静态且初始规划无误,因而鲁棒性较差。

- L2 - 反应式规划 (Reactive Planning):此阶段规划进化为闭环控制。智能体不再仅被动分解任务,而是能与环境交互,并根据反馈调整行为。ReAct框架[28]是典型代表,它将推理(Reason)和行动(Act)交织在一起,形成“思考-行动-观察”的循环。智能体能够调用外部工具(如搜索引擎)来获取完成任务所需的信息,从而感知环境并做出反应。这种闭环交互显著提升了智能体在动态环境中的适应性。