The Rise and Potential of Large Language Model Based Agents: A Survey

-

ArXiv URL: http://arxiv.org/abs/2309.07864v3

-

作者: Xiao Wang; Yicheng Zou; Yuhao Zhou; Yongyan Zheng; Wenjuan Qin; Rui Zheng; Ming Zhang; Wenxiang Chen; Senjie Jin; Wensen Cheng; 等20人

-

发布机构: Fudan University

The Rise and Potential of Large Language Model Based Agents: A Survey

背景

本章节旨在为后续内容奠定基础,首先追溯人工智能智能体 (AI Agent) 从哲学到AI领域的起源,并探讨人工实体是否具有智能体性的哲学思辨。接着,从技术趋势的角度回顾AI智能体的发展简史。最后,详细阐述智能体的关键特性,并论证为何大语言模型 (Large Language Models, LLMs) 适合作为AI智能体大脑的核心。

AI智能体的起源

“智能体 (Agent)”的概念源于哲学,其核心思想可追溯至亚里士多德和休谟等思想家。广义上,智能体指具有行动能力的实体;狭义上,指拥有欲望、信念、意图并能执行有意图行动的实体。当这一概念被引入AI领域时,其内涵发生了变化。哲学中的智能体可以是人、动物或任何自主实体,而AI中的智能体是计算实体。

由于意识、意图等概念对于计算实体而言具有形而上学的性质,AI研究者(如图灵)倾向于搁置“机器是否真正在思考”的问题,转而使用一组可观察的属性来描述AI智能体,如自主性 (autonomy)、反应性 (reactivity)、主动性 (pro-activeness) 和 社交能力 (social ability)。本文将AI智能体定义为:能够使用传感器感知环境、进行决策并利用执行器采取行动的人工实体。

智能体研究的技术趋势

AI智能体的发展经历了多个技术阶段:

- 符号智能体 (Symbolic Agents):早期AI智能体依赖符号逻辑和规则进行推理,具备可解释的推理框架,但难以处理不确定性和大规模现实世界问题。

- 反应式智能体 (Reactive agents):这类智能体不进行复杂的符号推理,而是基于“感知-行动”循环直接对环境变化做出快速反应,计算资源消耗少,但缺乏高级规划能力。

- 基于强化学习的智能体 (Reinforcement learning-based agents):随着深度学习的发展,深度强化学习 (Deep Reinforcement Learning, DRL) 使智能体能从高维输入中学习复杂策略,在游戏、机器人控制等领域取得巨大成功(如AlphaGo)。但其面临训练时间长、样本效率低和稳定性等挑战。

- 具备迁移学习和元学习的智能体 (Agents with transfer learning and meta learning):为解决强化学习的泛化难题,研究者引入迁移学习和元学习,使智能体能将在源任务上学到的知识快速应用于新任务,提高学习效率。

- 基于大语言模型的智能体 (Large language model-based agents):LLMs凭借其强大的知识、推理、规划和泛化能力,成为构建通用AI智能体的理想基础。研究者将LLM作为智能体的“大脑”或“控制器”,通过多模态感知和工具使用来扩展其感知与行动空间,使其展现出前所未有的综合能力。

为什么LLM适合作为智能体大脑的主要组成部分?

LLM具备成为AI智能体大脑核心的几项关键特性:

- 自主性 (Autonomy):LLM能够在没有人类详细干预的情况下,独立生成文本、制定计划并执行任务(例如Auto-GPT),展现出对自身行动和内部状态的控制力。

- 反应性 (Reactivity):通过多模态融合与工具使用,LLM的感知和行动空间得以扩展,使其能够感知并响应文本以外的视觉、听觉等环境变化,并与物理世界进行有效交互。

- 主动性 (Pro-activeness):LLM展现出强大的推理与规划能力。通过思维链 (Chain-of-Thought, CoT) 等技术,智能体可以进行逻辑推理;通过任务分解、目标重构等方式,智能体能够主动采取措施以实现目标。

- 社交能力 (Social ability):LLM强大的自然语言理解与生成能力,使其能与其他智能体或人类进行高效、可解释的互动,这是其社交能力的基础。基于此,多智能体系统能够通过协作或竞争完成复杂任务。

智能体的诞生:构建基于LLM的智能体

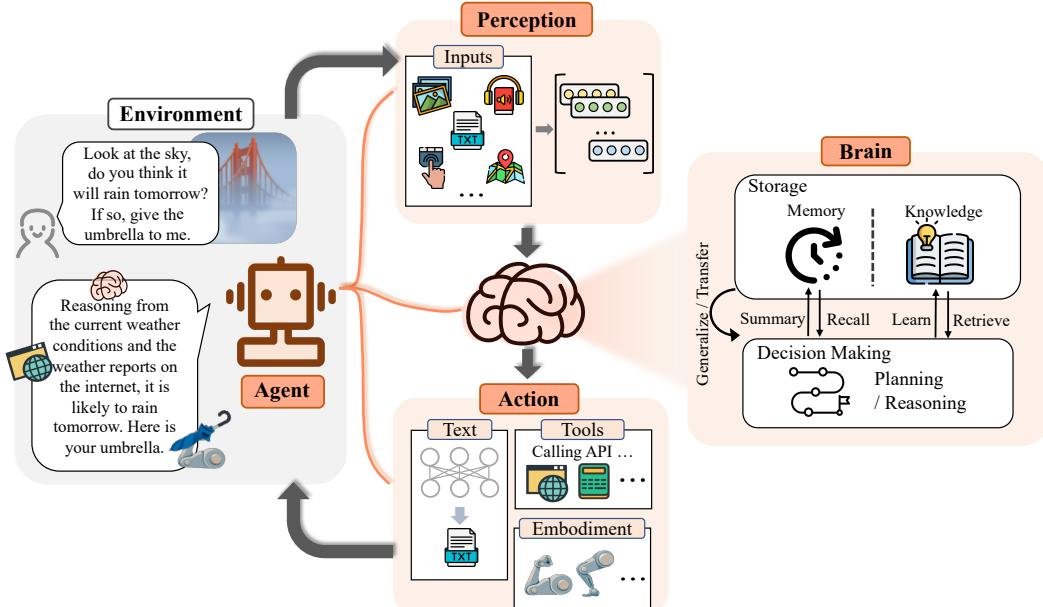

本文提出了一个构建基于LLM的智能体的通用概念框架,该框架受生物“适者生存”法则启发,包含三个核心组件:大脑 (Brain)、感知 (Perception) 和 行动 (Action)。此框架具有可定制性,并非所有应用都会用到每个组件。

其工作流如下:

- 感知模块 负责感知外部环境的多模态信息(如文本、图像、声音),并将其转换为大脑可理解的表征。

- 大脑模块 作为控制中心,负责思考、决策、推理、规划,并与知识库和记忆交互。

- 行动模块 负责执行大脑的指令,通过使用工具或执行具体动作来影响环境。

通过“感知-思考-行动”的循环,智能体能够持续与环境互动并获得反馈,不断迭代和优化自身行为。

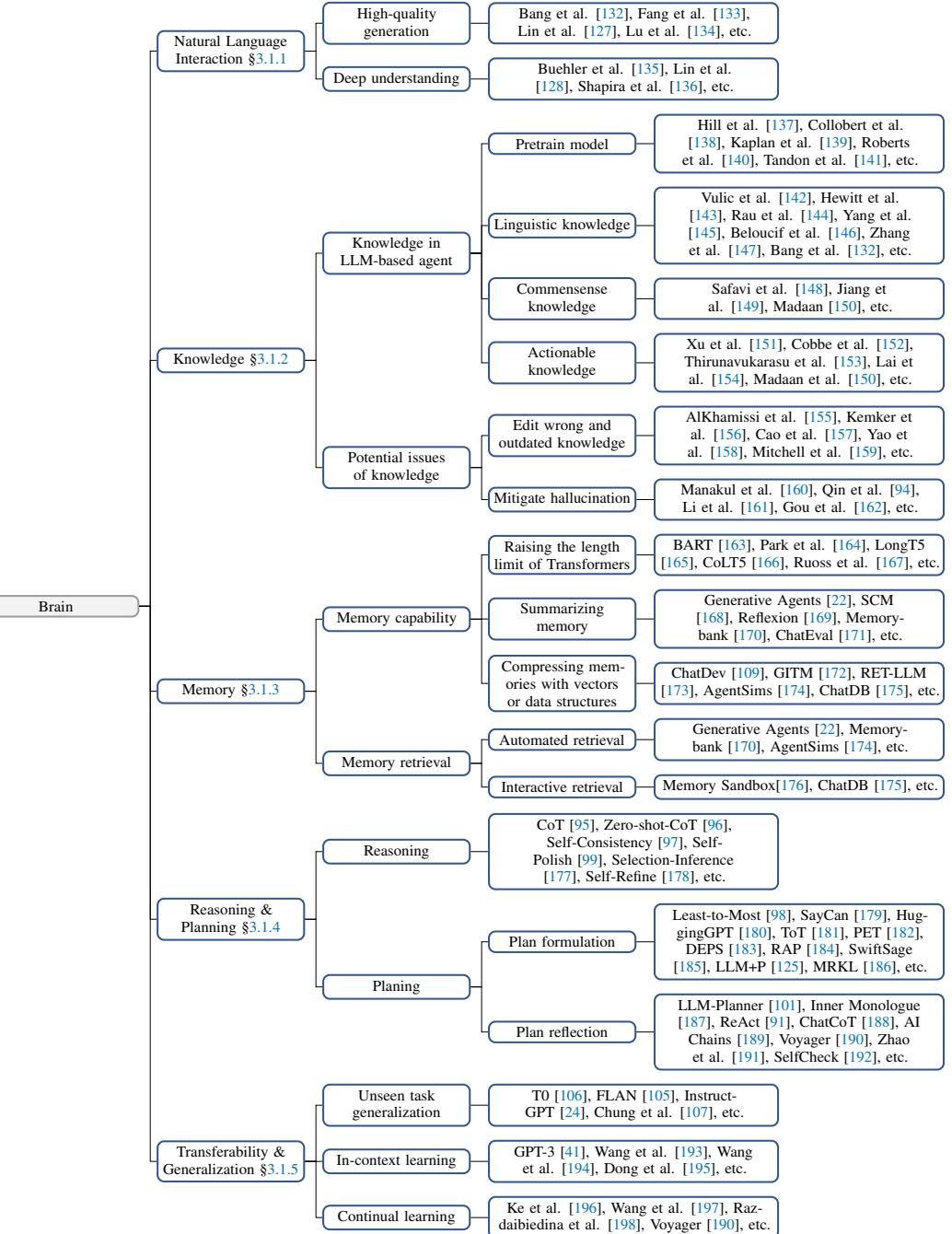

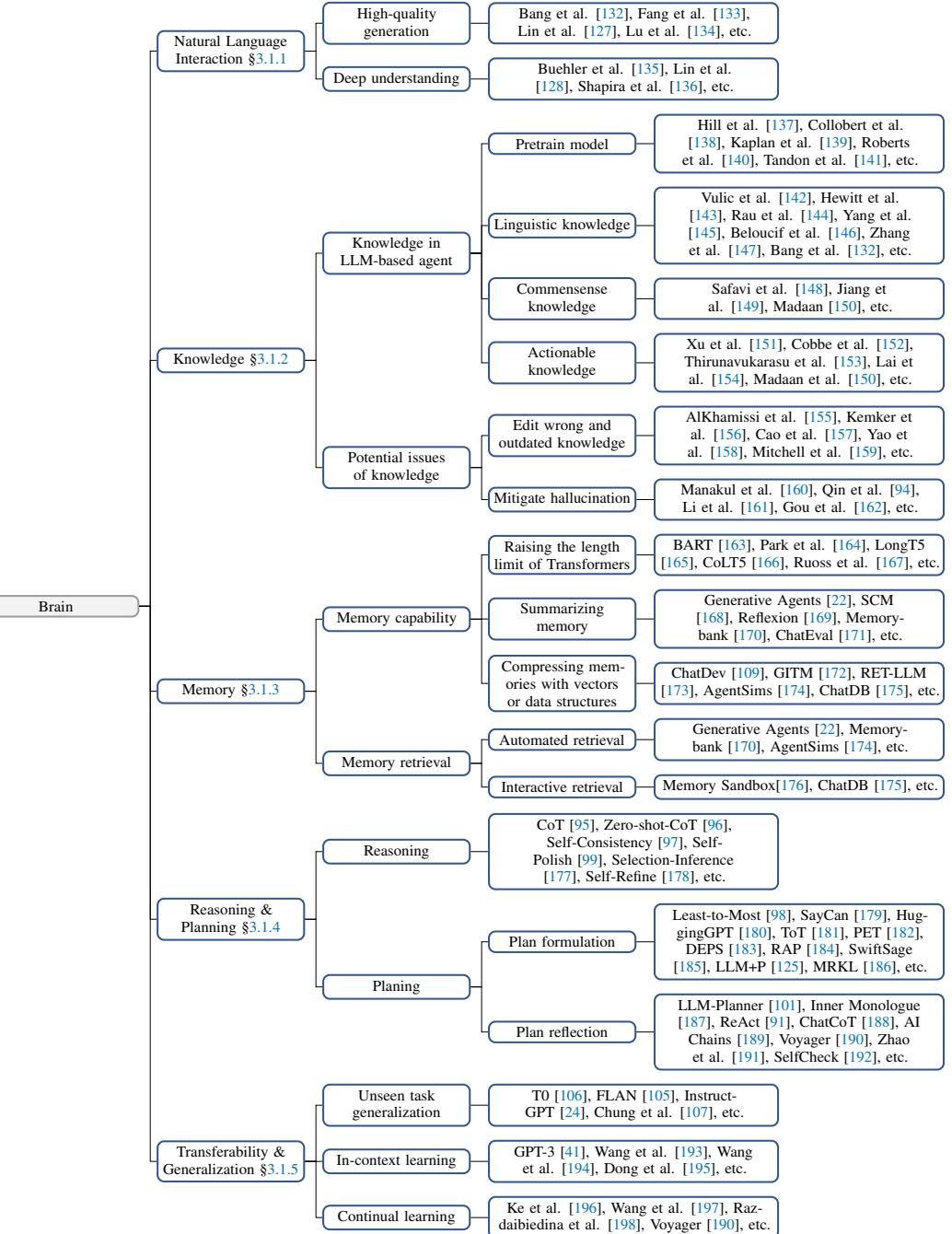

大脑

大脑是智能体的核心,主要由一个LLM构成。它负责信息处理、决策制定,并存储关键的知识和记忆。大脑模块的能力决定了智能体是否能表现出智能行为。

大脑模块的运行机制包括以下几个关键方面:

自然语言交互

LLM强大的自然语言能力是智能体与人类及其他智能体高效沟通的基础。

- 多轮交互对话:GPT系列、LLaMA系列等模型能够理解上下文,生成连贯、相关的回复,从而在多轮对话中有效解决问题。

- 高质量自然语言生成:现代LLM能够生成语法正确、风格一致且具有一定创造性的高质量文本。

- 意图与内涵理解:除了字面意思,智能体还需要理解语言背后的隐含意图。通过奖励建模等方式,智能体可以从模糊指令或反馈中推断用户的真实偏好。

知识

LLM通过在海量数据上预训练,将广泛的知识编码到其参数中,这些知识是智能体做出明智决策的基础。

- 语言知识:包括形态学、句法、语义学等,是理解和生成语言的基础。

- 常识知识:关于世界的基本事实(如“伞是用来挡雨的”),对理解语境至关重要。

- 专业领域知识:特定领域的知识,如编程、医学、数学等,是解决专业问题的关键。

尽管LLM知识渊博,但仍面临知识过时和幻觉 (hallucinations)(即生成与事实不符的内容)等挑战。解决方法包括模型编辑、利用外部工具进行事实核查等。

记忆

记忆存储了智能体过去的所有观测、思考和行动序列,对于处理长序列任务和从经验中学习至关重要。当前面临两大挑战:

- 历史记录过长:随着交互轮次增加,输入序列可能超出Transformer架构的长度限制。

- 相关记忆提取困难:从海量历史记录中快速准确地找到相关信息非常困难。

为提升记忆能力,研究者提出了几种方法:

- 提升Transformer长度限制:通过文本截断、分段处理或改进注意力机制来处理长序列。

- 记忆总结:使用LLM对历史交互进行总结,提炼关键信息,形成简明的记忆表示。

- 用向量或数据结构压缩记忆:将记忆嵌入为向量并存储在向量数据库中,通过相似性搜索高效检索相关记忆。此外,树状、图状等数据结构也被用来组织和管理记忆。

推理与规划

推理和规划能力使智能体能够将复杂任务分解为可执行的子任务,并形成行动计划。

- 推理:LLM通过思维链(CoT)、自我批判等提示策略,能够模拟人类的逐步推理过程,解决需要逻辑、数学或常识推理的任务。

- 规划:智能体利用LLM进行任务分解,生成详细的行动步骤。此外,通过反思和反馈机制(如ReAct, Reflexion),智能体能够评估过去的行动,修正错误,并动态调整计划。

可迁移性与泛化能力

LLM在多样化的大规模语料上进行预训练,获得了强大的泛化能力,使其能够适应未曾见过的新任务。

- 零样本/少样本学习 (Zero-shot/Few-shot Learning):无需或仅需少量示例,智能体就能理解新任务并执行。

- 跨任务泛化:智能体可以将从一个任务中学到的技能和知识迁移到另一个完全不同的任务上。

感知

感知模块扩展了智能体的输入来源,使其能够接收和理解来自外部世界的多模态信息。

- 文本输入:这是LLM的基础,智能体通过文本接收指令和信息。

- 视觉输入:通过视觉编码器(如ViT)或多模态大模型(如GPT-4V),智能体能够理解图像和视频内容,为与物理世界互动提供了基础。

- 听觉输入:结合自动语音识别(ASR)技术,智能体能将语音转换为文本,从而理解口头指令。

- 其他输入:未来可能包括触觉、嗅觉等更丰富的感知模态,使智能体更全面地感知环境。

行动

行动模块是智能体影响和改变环境的手段,扩展了其输出能力。

- 文本输出:智能体最基本的行动方式,通过生成文本来回应、交流或记录思考。

- 工具使用 (Tool Using):通过调用外部API或工具(如搜索引擎、计算器、代码执行器),智能体能够弥补LLM自身在实时信息获取、精确计算等方面的不足。这极大地扩展了智能体的能力边界。

- 具身行动 (Embodied Action):将智能体与机器人等物理实体结合,使其能够在物理世界中执行抓取、导航等具体动作。这通常需要将LLM的高级指令(如“拿起苹果”)转化为机器人可执行的低级控制命令。

实践中的智能体:驾驭人工智能以造福社会

本章详细介绍了基于LLM的智能体在实际应用中的部署,旨在“驾驭人工智能以造福社会”。

单智能体的一般能力

单个智能体在不同场景下展现出多样的部署模式和能力。

- 任务导向部署 (Task-oriented Deployment):智能体专注于完成特定任务,如软件开发(自动生成、调试代码)、科学探索(进行假设、设计实验)和办公自动化(处理邮件、安排日程)。

- 创新导向部署 (Innovation-oriented Deployment):智能体被用于激发创造性工作,例如在材料科学中发现新材料,或在社会科学中进行模拟实验。

- 生命周期导向部署 (Lifecycle-oriented Deployment):这类部署侧重于智能体的持续生存和适应能力。在模拟环境(如《我的世界》)中,智能体展现了从零开始学习、探索、制作工具和适应环境的类人行为。

多智能体的协调潜力

多个智能体通过互动,可以完成单个智能体难以解决的复杂任务。

- 互补的协作互动 (Cooperative Interaction for Complementarity):不同角色的智能体(如程序员、测试员、产品经理)组成团队,通过分工协作共同完成复杂的软件开发项目。这种协作模式提高了任务完成的效率和质量。

- 促进进步的对抗互动 (Adversarial Interaction for Advancement):通过辩论、竞争或“红队演练”等对抗性互动,智能体可以相互挑战,发现彼此的弱点和偏见,从而提升各自的能力和鲁棒性。例如,一个智能体负责生成内容,另一个负责批判,从而迭代出更高质量的输出。

人类与智能体的互动参与

考虑到LLM在隐私、伦理和决策可靠性方面的局限,人机协作变得至关重要。

- 指导者-执行者范式 (Instructor-Executor Paradigm):人类扮演指导者角色,确定目标并监督过程,而智能体作为执行者,负责具体的任务实施。人类可以在关键节点进行干预和修正,确保任务按预期进行。

- 平等伙伴关系范式 (Equal Partnership Paradigm):人类和智能体作为平等的伙伴共同工作,智能体可以提供建议、分析和创意,而人类则利用自己的直觉和领域知识进行决策。这种模式常见于头脑风暴、设计和研究等创造性任务中。

智能体社会:从个体性到社会性

本章探讨了当多个智能体共同存在并互动时所形成的“智能体社会”,以及从中涌现出的复杂现象。

基于LLM的智能体的行为与个性

- 社会行为:研究表明,LLM智能体能够展现出复杂的社会行为,如合作、欺骗、以及在“社会困境”问题(如囚徒困境、公地悲剧)中做出类似人类的决策。它们的行为会受到群体动态和社会规范的影响。

- 个性:通过特定的提示或微调,可以为LLM智能体赋予不同的人格特质(如外向、内向、尽责等),使其在互动中展现出一致且可信的个性。这对于模拟多样化的社会群体至关重要。

智能体社会的环境

智能体社会的存在和演化需要一个环境作为载体。

- 基于文本的环境 (Text-based Environment):最简单的环境,智能体通过纯文本进行所有互动和行动。

- 虚拟沙盒环境 (Virtual Sandbox Environment):提供一个更丰富的虚拟世界(如斯坦福的“小镇”模拟),智能体拥有化身,可以在其中移动、互动和改变环境,从而研究更复杂的社会现象。

- 物理环境 (Physical Environment):将智能体部署在真实世界的机器人上,使其在物理空间中互动。这是最具挑战性的环境,也是通向通用人工智能的关键一步。

基于LLM的智能体社会模拟

通过构建智能体社会,研究者可以模拟和研究复杂的社会现象。

- 智能体社会的核心属性与机制:模拟社会能够再现人类社会中的信息传播、观点形成、社会关系演变等现象。例如,研究发现模拟社会中会自然形成意见领袖和社交网络结构。

- 从智能体社会中获得的洞见:这些模拟为社会科学研究提供了一个可控的“数字培养皿”,可以用来测试社会学理论、预测社会动态,甚至探索公共政策的潜在影响。

- 智能体社会中的伦理与社会风险:模拟社会也带来了风险,如偏见和刻板印象的放大、错误信息的快速传播,以及可能被用于操纵舆论。这些都需要在设计和部署时予以高度关注。

讨论

本章探讨了基于LLM的智能体研究中的几个关键议题和开放性问题。

LLM研究与智能体研究的互惠互利

LLM的发展推动了智能体研究的进步,而智能体的研究也为LLM的优化提供了新思路。智能体的任务执行过程和与环境的互动数据,可以作为高质量的训练数据,通过持续学习来增强LLM的能力,形成一个良性循环。

基于LLM的智能体评估

如何评估智能体的能力是一个核心挑战。本文提出评估应涵盖四个维度:

- 效用 (Utility):完成任务的效率和效果。

- 社会性 (Sociability):与其他智能体或人类的协作和沟通能力。

- 价值观 (Values):行为是否符合人类的伦理和价值观。

- 持续进化能力 (Ability to continually evolve):学习和适应新环境、新任务的能力。

安全性、可信赖性及其他潜在风险

- 对抗性鲁棒性 (Adversarial Robustness):智能体容易受到对抗性攻击(如越狱提示),导致其产生有害或不当行为。

- 可信赖性 (Trustworthiness):由于幻觉、偏见等问题,智能体的决策和输出并不总是可靠,在关键领域的应用需要谨慎。

- 其他潜在风险:包括滥用(如用于网络攻击)、导致失业、以及对人类福祉构成长期威胁等。

扩展智能体数量

扩展智能体社会的规模既带来了机遇(如涌现出更复杂的集体智能),也带来了挑战(如计算成本、通信开销和行为管理的复杂性)。如何有效地管理和协调大规模智能体群体是未来研究的重要方向。

开放性问题

该领域仍有许多悬而未决的问题有待探索:

- 通往AGI的路径? 基于LLM的智能体是否是实现通用人工智能(AGI)的一条可行路径,目前尚无定论。

- 从虚拟到物理的挑战:如何将智能体在模拟环境中学到的技能无缝迁移到复杂的、不可预测的物理世界(即“Sim-to-Real”问题),是一个巨大的技术障碍。

- AI智能体中的集体智能:如何设计机制使大量智能体能够涌现出超越个体能力总和的集体智能?

- 智能体即服务 (Agent as a Service, AaaS):未来是否会出现一个平台,让用户可以像使用云服务一样,轻松创建、部署和组合各种功能的智能体来解决个人或企业问题。

结论

本文对基于大语言模型的智能体进行了全面综述。首先,回顾了智能体概念的起源和技术发展;其次,提出了一个由大脑、感知和行动三部分构成的智能体构建框架,并详细阐述了每个模块的关键技术;接着,探讨了单智能体、多智能体以及人机协作的广泛应用;然后,深入分析了智能体社会的行为、环境和模拟,以及其中涌现的社会现象;最后,讨论了该领域的关键议题和开放性问题。基于LLM的智能体是一个充满活力和巨大潜力的新兴领域,有望在通往通用人工智能的道路上扮演关键角色。